将 离线AI(如本地LLM大模型、强化学习模型) 接入 离线版《逃离塔科夫》(SPT-AKI或其他单机版),让NPC(如Scav、PMC)变得更智能,可以通过以下几种方案实现,从简单到复杂逐步深入:

方案 1:修改AI行为配置文件(简单,适合基础调整)

适用场景

-

调整NPC的 战斗风格、移动逻辑、反应速度。

-

无需编程,直接修改游戏配置文件。

实现方法

-

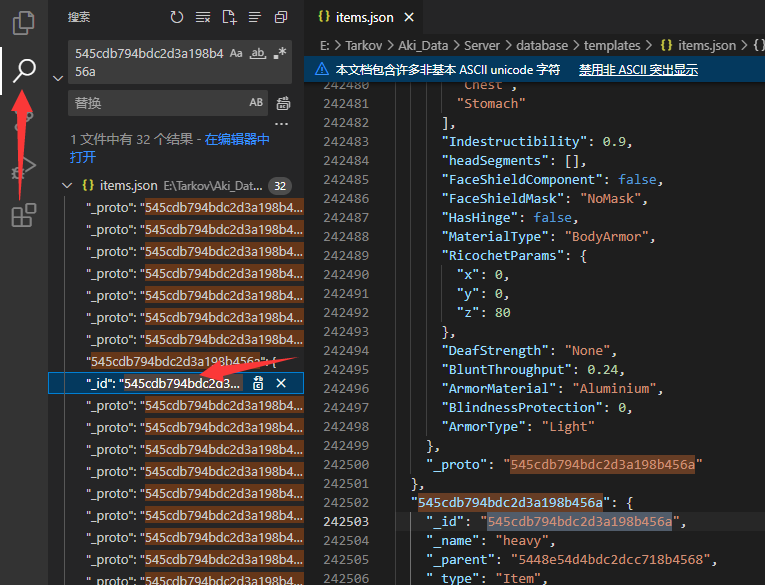

找到塔科夫的AI配置文件(以SPT-AKI为例):

-

base.json(基础AI行为) -

pmc.json(PMC Bot逻辑) -

scav.json(Scav Bot逻辑) -

路径通常位于:

SPT-AKI\server\database\bots

-

关键文件:

-

调整关键参数:

{ "AIMinDist": 5, // 最小攻击距离 "AIMaxDist": 100, // 最大攻击距离 "AIMinSpread": 0.5, // 最小子弹散布(影响精准度) "AIMaxSpread": 3.0, // 最大子弹散布 "AIMinRecoil": 0.1, // 最小后坐力控制 "AIMaxRecoil": 1.5, // 最大后坐力控制 "AIMinVision": 20, // 最小视野范围(米) "AIMaxVision": 100, // 最大视野范围 "AIMinHearing": 10, // 最小听力范围 "AIMaxHearing": 50, "AIMinSpeed": 0.5, // 移动速度系数 "AIMaxSpeed": 1.2, "AIMinAggression": 0.1, // 攻击性(0-1) "AIMaxAggression": 0.9} -

测试效果:

-

调整后重启SPT-AKI服务器,观察NPC行为变化。

优缺点

✅ 无需编程,快速调整。

❌ 无法实现真正的动态AI决策,仅能修改固定参数。

方案 2:使用Python脚本 + 外部AI决策(中等难度)

适用场景

-

让NPC 动态调整战术(如包抄、埋伏、撤退)。

-

结合 规则引擎 或 简单机器学习模型 控制NPC。

实现方法

-

利用SPT-AKI的Mod系统(如

BSG-Modding): -

编写一个Python脚本,监听NPC状态(位置、血量、敌人信息)。

-

使用 决策树(Decision Tree) 或 有限状态机(FSM) 控制NPC行为。

-

示例Python伪代码:

def decide_npc_action(npc_hp, player_distance, ammo_left): if npc_hp < 30 and player_distance < 20: return "retreat" elif ammo_left < 10: return "reload_and_cover" else: return "flank_and_attack"

-

与游戏通信:

-

通过 HTTP API 或 内存读写(如

CheatEngine+PyMem)动态修改NPC行为。

优缺点

✅ 比纯配置文件更灵活,可动态调整策略。

❌ 需要Python基础,且依赖外部通信。

方案 3:强化学习(RL)训练智能NPC(高级)

适用场景

-

让NPC学会 高级战术(如团队协作、动态寻路、武器选择)。

-

适合 AI研究 或 超高难度私服。

实现方法

-

搭建训练环境:

-

使用 Unity ML-Agents 或 Gymnasium 模拟塔科夫战斗场景。

-

或直接 Hook塔科夫进程 获取游戏数据(如NPC位置、玩家状态)。

-

训练RL模型(如PPO、DQN):

import torchfrom stable_baselines3 import PPO env = TarkovAIEnv() # 自定义环境model = PPO("MlpPolicy", env, verbose=1)model.learn(total_timesteps=100000)model.save("tarkov_ai_model") -

部署到SPT-AKI:

-

将训练好的模型集成到

BSG-Modding,动态控制NPC决策。

优缺点

✅ NPC可学会接近真人的战术。

❌ 开发成本极高,需机器学习知识。

方案 4:LLM(大语言模型)驱动NPC对话(沉浸感增强)

适用场景

-

让Scav/PMC 能智能对话(如谈判、嘲讽、投降)。

-

结合 本地LLM(如Llama 3、ChatGLM3)。

实现方法

-

本地运行LLM(如

Ollama+Llama 3):ollama pull llama3 ollama run llama3 "你是一个塔科夫Scav,用俄语回答玩家"

-

Mod接入LLM API:

-

在SPT-AKI的对话事件中调用LLM生成回复:

def get_scav_response(player_text): response = query_llm(f"Player says: {player_text}. Respond as a Scav:") return response -

游戏内效果:

-

玩家按

F1对话 → NPC用 语音/文字 智能回复。

优缺点

✅ 极大提升沉浸感,适合RP服务器。

❌ LLM可能反应较慢,需本地GPU支持。

推荐工具总结

| 用途 | 推荐工具 |

|---|---|

| 基础调整 | SPT-AKI的 bots 配置文件 |

| 动态决策 | Python + 决策树/状态机 |

| 高级AI训练 | PyTorch + Stable-Baselines3 |

| NPC对话 | Ollama + Llama 3/ChatGLM3 |

| 游戏通信 | HTTP API、内存修改(PyMem) |

最终建议

-

只想微调难度? → 方案1(改配置文件) 最简单。

-

希望NPC有基本战术? → 方案2(Python脚本) 更灵活。

-

追求终极智能NPC? → 方案3(强化学习),但需要AI专业知识。

-

增强对话沉浸感? → 方案4(LLM + 语音合成)。

如果是 个人娱乐,建议从 方案1或2 开始;如果是 研究/硬核私服,可以挑战 方案3或4。

本地部署的DEEPSEEK 7B模型或者8B模型对本地负载也不高,只要有合适的方案应该可以实现吧

3.10.2

文字描述

是

其他问题

以上AIGC全是驴头不对马嘴的胡话,eft的bot运行方式完全不适合接入大模型

除了第一个别的恐怕完全没可能,动态调整这块基本只能等牢尼自己先开这个头了![[s-21]](https://static.oddba.cn/sns/emoji/1/21.png)